COLUMN

コラム

セキュリティコラム

最新動向

AIを活用したサイバーセキュリティ対策 情報セキュリティ大学院大学

大塚教授に訊く「AI for Security」の最新事情

2025.06.11

ChatGPTをはじめとした生成AIの進化は日進月歩であり、次々と新しいモデルやサービスが発表されています。AI技術は私たちの生活や社会に大きな影響を与えています。

そうした生成AIの力をセキュリティに利活用するという考え方が「AI for Security」です。

本稿では、AIセキュリティや暗号理論を主に研究されている、情報セキュリティ大学院大学の大塚玲教授にお話をお伺いした内容を元に、AIを活用したセキュリティの最新事情について解説します。

プロフィール

情報セキュリティ大学院大学 大塚玲教授、博士(工学)

電子情報通信学会バイオメトリクス研究専門委員会顧問

JNSAサイバーセキュリティ産学連携協議会代表

人工知能学会 安全性とセキュリティ研究会(SIG-SEC)主査

1991年 大阪大学工学研究科博士前期課程修了。同年より野村総合研究所。

2002年 東京大学大学院工学系研究科電子情報工学専攻博士課程修了。

2005年4月-2017年3月 産業技術総合研究所。

2006年-2010年 産業技術総合研究所情報セキュリティ研究センター・セキュリティ基盤技術研究チーム長。

2007年-2014年 中央大学研究開発機構教授。

2017年4月より情報セキュリティ大学院大学教授。

AIセキュリティや暗号理論、ブロックチェーンなどの研究を行っている。

●AIはセキュリティにおける諸刃の剣

情報セキュリティ大学院大学 大塚玲教授

「AI for Security」とは、セキュリティのためのAIと訳され、AIを使ったサイバー攻撃およびAIを使った攻撃手法の解析や防御についての考え方を指します。AIを活用したセキュリティ製品の開発が進む一方で、サイバー攻撃そのものにAI技術を用いられ新たな攻撃手法が広まるなど、AIはセキュリティにおいては防御としての備えでもあり、脅威でもあります。AI for Securityという言葉には、その両面が含まれています。

「AI for Security」と類似した用語に「Security of AI」、「Security for AI」があります。これらは、例えば不正アクセスによりAIの学習データが漏洩するリスクなどAIそのものを守るためのセキュリティを指しています。

生成AIをセキュリティの分野に応用しようとする考え方が広がる契機となったのが、「スケーリング則」と呼ばれる経験則を用いて、飛躍的にLLM(大規模言語モデル)の性能が向上したことです。スケーリング則を簡単に言うと、言語モデリングの性能はリソースを投入するほど高くなるということです。

2022年11月に米国OpenAI社が公開したChatGPTは、従来のAIを遥かに超える汎化性能を実現していたことで大きな話題となりました。このLLM性能向上の鍵を握るのがスケーリング則です。

大塚教授は、トレーニングデータに対してパラメータ数を多くしすぎると汎化性能が低下するというこれまでの定説が、ChatGPTによって覆されたと説明します。

「パラメータ数とデータセットサイズと計算リソース量の三つの要素を一定のルールに従って同時に大きくしていくことで、いくらでも賢くなるということが経験的に明らかになってきたのです。そこで、巨大な投資をしてもっと賢いAIを作ろうという競争が始まり、GoogleやMetaなどのビッグテックが相次いでLLMを利用したサービスを次々とリリースしました。このような流れから、賢いAIをセキュリティの分野に活用する動きが広がっていきました」

AIの学習方法の一つに「強化学習」があります。強化学習とは、与えられた正解を学ぶものではなく、成功すると報酬が与えられる仕組みによって、繰り返し経験を積む中で新しい知見を獲得していくものです。

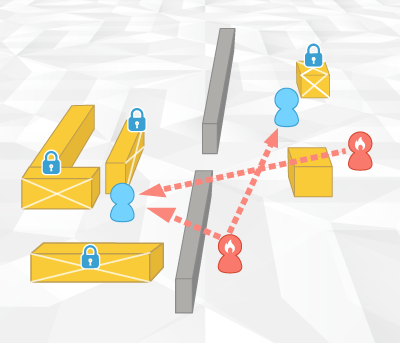

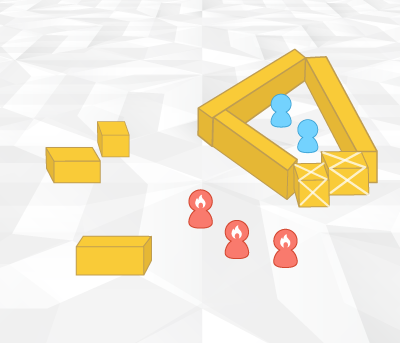

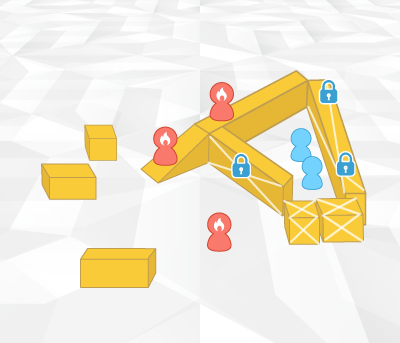

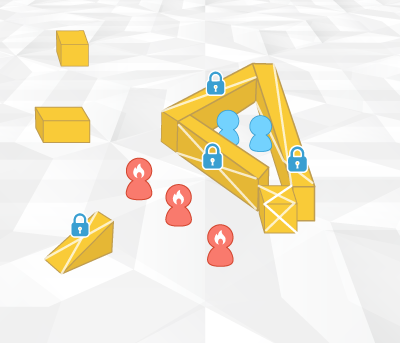

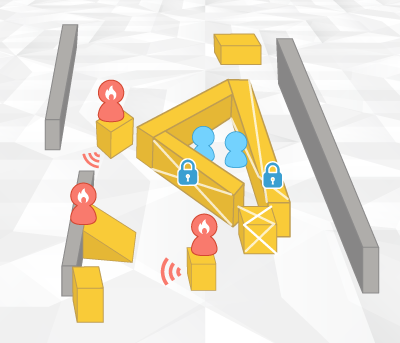

大塚教授は、強化学習によって攻防知識が獲得されることを、"鬼ごっこ"の実験結果を例に示しました。(下記図解参照)

OpenAIの研究"Emergent tool use from multi-agent interaction"※によれば、強化学習によって鬼ごっこを行わせると、最初は鬼に捕まっていた逃げる側が、シェルターを作って立てこもるという新たな知識を獲得し、逃げる側が一方的に勝つ試合が続きます。すると今度は鬼がスロープをシェルターのそばに持っていって上から攻めるという技を身につけ、鬼が勝つようになります。さらに試合を続けると、逃げる側が新しい戦術を見つけ出し逆転する・・・、といったように追いかける鬼と逃げる側は、時間が経つにつれ交互に新しい戦術を見つけ出し、優劣が入れ替わります。実験結果では、最終的には逃げる側が、鬼が考案した攻撃手段をすべて封じて勝つようになりました。

このように、AIは互いに競わせることでどんどん進化する性質があります。こうしたAIの性質は、セキュリティ対策にも適しています。セキュリティには、攻撃側と防御側の知恵比べといった側面があるからです。

1 追跡攻撃を獲得

2 ブロックを使ってシェルターを構築

3 スロープを使ってシェルターを突破

4 スロープを固定してスロープ攻撃から防御

5 ボックスサーフィン攻撃を獲得

6 ボックスサーフィン攻撃から防御

注:上記図はOpenAIの記事"Emergent tool use from multi-agent interaction"を元に再構成したものです。

●Gemini 1.5 Pro がマルウェアのソースコードを瞬時に解析

大塚教授が注目する、セキュリティ分野における生成AI(LLM)を活用した防御の好例が、2024年5月に日本で提供が開始されたGoogle社の「Gemini 1.5 Pro」による未知のマルウェアの解析レポート自動生成です。Gemini 1.5 Proでは、LLMに入力できる文字列のサイズが200万トークンに拡張されました。Gemini 1.5 Proに、未知のマルウェアのバイナリ(実行ファイル)を逆コンパイラでソースコードに変換したものを投入し、解析レポートを生成するように指示をしたところ、WannaCry型のランサムウェア系マルウェアであることを特定しました。さらに、逆コンパイルコード上で具体的なURLを指定した外部との不正な通信痕跡の検出といった、従来であれば専門家が何週間もかけて解析していた内容を、僅か数分程度で出力したのです。

ここで注目すべきことは、このGemini 1.5 Proは、特別にマルウェアに関する知識などを追加学習させたものではないことです。Gemini 1.5 Proを追加学習させることなくそのまま使って、どのタイプのマルウェアか判別し、マルウェアの解析が行えるということです。さらに性能の高いAIが登場すれば、ハルシネーション(幻覚・事実とは異なる説明)が抑制されて、信頼できる解析結果を出力できるようになるでしょう。

大塚教授は、マルウェア解析用としてチューニングしたセキュリティ特化型LLMが近い将来に登場すると予測しています。

●AIが自律的に判断を行う「自律サイバー推論システム」、AIと人間がタッグを組んでセキュリティ対策を行う時代へ

AIは、企業のセキュリティ対策において大きな役割を果たします。

例えば、情報システムのセキュリティ管理です。従来型の管理では、セキュリティインシデントが検出されるとシステムから警報が出され技術者が対応します。昨今では、システムの大規模化、複雑化に伴い24時間365日の対応が求められる場合もあります。さらに、攻撃側がAIを使ってフィッシングメールの文面を作ったり、マルウェアの変種を作ったりするなど、より高度で巧妙な攻撃を仕掛けてくるため、防御する側もさらに強固な対策を講じる必要性が増しています。しかしながら、人間の処理スピードには限界があります。

そこで期待されているのが「自律サイバー推論システム」(サイバーリーズニングシステム)の開発です。これはLLMで自律的にサイバー攻撃に対応する仕組みです。人間に代わってAIがセキュリティログを解析し、何が起きていて、どういうアクションを取らなければいけないかを判断するものです。軽微なものについてはAI側が自動的に対処を行い、重要な判断を人間が行うことになります。

大塚教授は、セキュリティ対策において、自律サイバー推論システムを活用する可能性に注目しています。

「強化学習によって鬼ごっこの攻防知識が獲得されたように、自律サイバー推論システムを使って攻防のイタチごっこを行わせることで、高度な"イタチ"の作成が可能となります。強いイタチを作って防御することが大切です」

自律サイバー推論システムでは、重大な意思決定が必要な場合を除き、AIが自律的にサイバー攻撃への対応を行います。システムシャットダウンなど事業の継続に影響を与えるような重大な意思決定については人間の判断が求められます。AIが常に100%正しい判断をするとは限らないからです。自律サイバー推論システムは、人間が重大な意思決定を行う際に判断の根拠となる、エビデンスを示してくれます。つまり、AIと人間がタッグを組んで、それぞれの特性を活かしてセキュリティ対策を行う未来が実現するのです。

大塚教授によると、LLMなど高度なAIを搭載したセキュリティ製品やサービスの本格的な商用化は、これからと言えそうです。

「AIを活用したセキュリティ製品は各社から以前より発売されていますが、それら従来の方式と比べるとLLMを用いたセキュリティソリューションは遥かに性能が高くなります。しかし、LLMを用いたセキュリティ製品が市場に普及していないのは、LLMの進化が急激で技術の陳腐化スピードが速いため、まだ本格的な展開に至らないというのが現状ではないでしょうか」

●AIをセキュリティ対策に活用する上でのリスク

LLMなどのAIを企業がセキュリティ対策として活用する上でのリスクは、大きく2つあります。

1つ目は、情報が漏えいするリスクや国内法が及ぶ範囲(法域)から外れてしまうといったリスクです。特に、クラウド上に構築されているLLMを利用する場合に注意が必要です。そのため、クライアントのPCやオンプレミスのサーバーなど、ローカル環境で稼働するLLMの重要性が増す可能性があります。将来的にはAI機能付きのさまざまなアプリケーションが開発され、エッジAIが重要になっていくことも予想されます。

2つ目は、AIにより適切な意思決定が行われないリスクです。最近の自律サイバー推論システムでは、LLMが出した結果を別のLLMで検証し、事実に基づいているかを判断し、エビデンスとともに判断の根拠となった「リーズニング(理由付け)」を提示します。しかし、人間もその理由付けが正しいのかを自身で判断し、対応する必要があります。つまり、AIの進化にあわせて、私たち人間もより賢くなる必要があるのです。

●AI導入は企業にとって必須、使う側の意識変革も必要

LLMに代表される生成AIを導入することによって、セキュリティ分野だけでなく、ビジネスにおけるさまざまな業務の効率を飛躍的に向上させることが可能です。

大塚教授は、企業の生産性を高めるために、AIへの先入観をなくし、積極的に活用することの重要性を強調します。

「企業の生産性を高めるためには、生成AIの導入が必須といえます。AIは技術革新のスピードが非常に速く、これから登場する生成AIを活用したさまざまなソリューションは、従来の製品とは隔世の感があります。伝統的なAIの延長線上で発展していると思わずに、一気にジャンプアップしたという理解のもとに新しいAIソリューションと向き合い、積極的に導入していく必要があると思います」

大塚教授は、AIの急速な進化についていくためには、それを使う側の意識や考え方にも変革が求められると述べました。

「インターネットの登場と同じように、AIを上手く使える人と使えない人で、大きな差が生じてくると思います。AIによって言語の壁も越えられますし、難解な大量の情報も効率よく処理できます。AIを上手に使いながら、自分がどういうアウトプットを出せばいいかということが重要です。AIから出力された情報を利用することを前提として、最適なアウトプットをどのように出せば良いか考える能力を各人が身につけなくてはいけません」

最後に、AI領域に関する大学教育についての大塚教授の考えを伺いました。

「日進月歩のAI研究は、授業だけでカバーすることはできません。基礎理論は授業で学べますが、研究開発のスピードが非常に速く、イノベーションがあちこちで起きています。常に最新の研究成果を追いかけ、追い越す気概を持ち、どの研究が伸びそうかといったセンスを磨いていくことが大切だと思います」

●生成AI+AI OCRソリューション「AI TextSifta」

生成AI関連ソリューションとして、さくら情報システムが開発した「AI TextSifta」を紹介します。

https://www.sakura-is.co.jp/solution/ps-000-158.html

企業の生産性を高め、企業価値の向上に繋がるDXの重要性が盛んに叫ばれていますが、多くの企業では依然として「アナログ情報のデジタル化」が課題となっています。紙などアナログ情報のデジタル化には、AI技術を採用したAI OCRが利用されることが多いのですが、通常のAI OCRでは、画像を文字に変換することはできても、さまざまなフォーマットが混在する帳票などから文字を認識し、適切な項目として入力することは苦手でした。「AI TextSifta」では、生成AIを利用することで、従来のAI OCRでは対応できなかった多様な帳票や写真などから、適切な項目としてテキストデータ化が可能です。

2024年6月から提供を開始した「AI TextSifta」は、厳しいセキュリティ対策が求められる大手金融機関を中心にさまざまな業務で活用されています。今後、OCR後のポスト処理をより充実させたサービスを提供する計画があるほか、目視チェックを併用したサービスも提供される予定です。具体的には、「AI TextSifta」の結果をAPIで動的に連携し、人の目で確認した上で「AI TextSifta」に戻し、その上で出力をポスト処理するというフローによって抽出したデータの精度を100%にすることを目標としています。

さくら情報システムでは、最新の技術を取り入れ、お客様の多様なニーズに対応できるよう開発に取り組んでいます。

(文責 ISBマーケティング株式会社)

出典:Baker, Bowen et al. qtd. in OpenAI."Emergent tool use from multi-agent interaction." マルチエージェントインタラクションからの創発的なツール使用.(2019年9月17日).https://openai.com/index/emergent-tool-use/,(2025年3月24日)